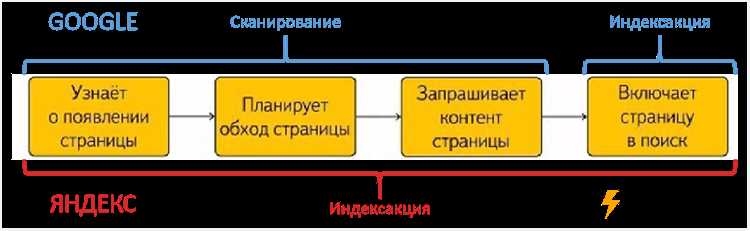

Индексация сайта является одним из ключевых факторов, определяющих его успешность в поисковой выдаче. Однако, не все страницы сайта автоматически попадают в индекс поисковиков. Почему некоторые страницы игнорируются, а другие успешно индексируются и поднимаются в выдаче? Ответ на этот вопрос будет полезен любому веб-мастеру, стремящемуся улучшить позиции своего сайта в поисковой выдаче.

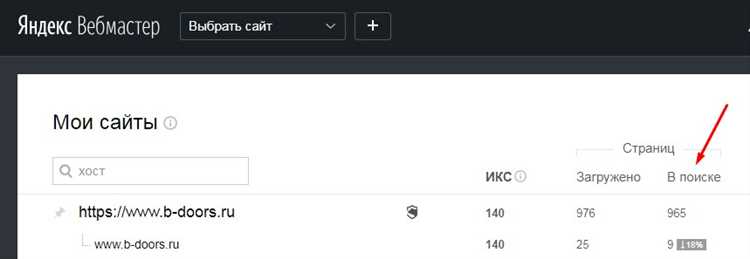

Статистика страниц в поиске является важным инструментом для анализа индексации сайта. Она позволяет увидеть, какие страницы успешно проиндексированы, а какие пока отсутствуют в поисковой выдаче. Исходя из этих данных, можно предпринять меры для улучшения индексации отдельных страниц или сайта в целом.

Часто причиной игнорирования поисковиками страниц сайта является некачественный контент. Поисковые системы стремятся предлагать пользователям только полезную и интересную информацию. Если контент страницы не соответствует этим требованиям, то есть большая вероятность, что она будет проигнорирована поисковиками и не попадет в индекс. Поэтому одной из первостепенных задач веб-мастера должно быть создание уникального и полезного контента для каждой страницы сайта.

Индексация сайта: статистика страниц в поиске, или почему поисковики игнорируют ваш сайт

Существует несколько причин, по которым поисковики могут игнорировать страницы вашего сайта. Одна из основных причин — это некорректная или недостаточная внутренняя структура сайта, которая не позволяет поисковым роботам эффективно проиндексировать все страницы. Также, поисковики могут игнорировать страницы, содержащие дублирующийся контент или низкокачественный контент, который не соответствует требованиям поисковиков.

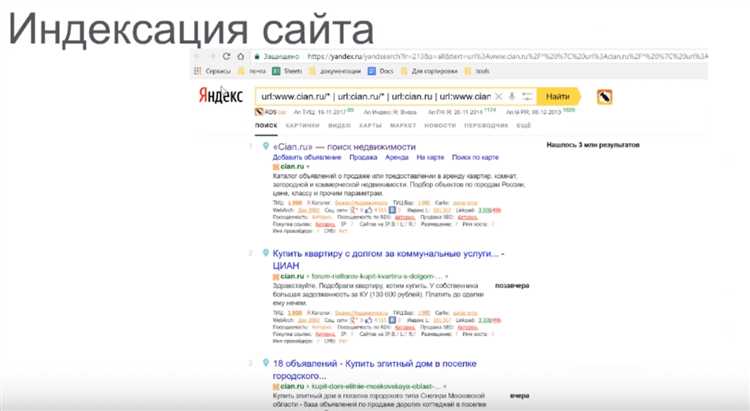

Для того чтобы узнать статистику индексации страниц вашего сайта, можно использовать специальные сервисы аналитики, предоставляемые поисковыми системами. Они позволяют проанализировать, какие страницы были проиндексированы поисковиками, как часто они появляются в поисковой выдаче и какие запросы пользователей приводят к их отображению. Эта информация позволяет оптимизировать сайт для лучшей индексации и улучшения его позиций в поисковой выдаче.

Важно понимать, что индексация страниц может занимать время и не все страницы могут попасть в индекс сразу. Поэтому регулярный анализ статистики индексации поможет выявить проблемные страницы и принять меры для их оптимизации. Кроме того, следует уделить внимание техническим аспектам, таким как правильное использование мета-тегов, файлов sitemap.xml и robots.txt, чтобы облегчить индексацию поисковыми системами.

Прежде чем начинать оптимизацию индексации страниц вашего сайта, необходимо провести анализ конкурентов в выбранной нише. Это позволит определить требования, которые поисковые системы предъявляют к сайтам в данной тематике, и способы эффективного привлечения органического трафика. Также, стоит выявить ключевые факторы, влияющие на индексацию страниц, такие как релевантность контента, качество внешних ссылок и социальные сигналы.

Отсутствие уникального контента

Одной из основных причин игнорирования поисковиками вашего сайта может быть его отсутствие уникального контента. Поисковые системы стремятся предоставлять пользователям максимально релевантные и полезные результаты поиска. Если ваш сайт содержит только скопированный контент или информацию, которая уже присутствует в большом количестве других источников, то поисковые системы могут решить, что ваш сайт не представляет собой ценной информацию и не стоит его индексировать.

Лучшим решением для привлечения внимания поисковых систем и увеличения видимости вашего сайта является создание уникального и полезного контента. Уникальный контент — это информация, которую нельзя найти нигде еще в интернете. Он может содержать оригинальные идеи, исследования, экспертные мнения или личный опыт, которые могут быть интересны и полезны вашей целевой аудитории. Помимо этого, поисковые системы обычно предпочитают сайты с большим количеством уникального контента, так как они считаются более авторитетными и информативными.

Уникальный контент также может привлекать ссылочную массу и повысить позиции вашего сайта в поисковой выдаче. Когда другие сайты ссылается на ваш контент, поисковые системы считают это внешним подтверждением качества вашего сайта и повышают его релевантность для конкретного запроса. Использование ключевых слов и фраз, связанных с вашей тематикой, в контенте и заголовках также может помочь поисковым системам понять и индексировать ваш сайт по соответствующим запросам.

Преимущества уникального контента:

- Повышение видимости сайта в поисковой выдаче

- Привлечение большего количества органического трафика

- Увеличение авторитетности и доверия поисковых систем к вашему сайту

- Постоянное обновление и расширение аудитории

- Возможность привлечь ссылочную массу

Низкая скорость загрузки страниц

Согласно исследованиям, большинство пользователей ожидают, что страницы загрузятся за несколько секунд. Если загрузка занимает слишком много времени, пользователи склонны покинуть сайт и найти информацию где-то ещё. Кроме того, поисковые системы учитывают скорость загрузки страниц при ранжировании результатов поиска — медленные сайты имеют меньше шансов быть высоко в списках.

Чтобы улучшить скорость загрузки своего сайта, следует обратить внимание на следующие аспекты:

- Сжатие изображений и использование форматов с низкой потерей качества (например, JPEG вместо PNG).

- Оптимизация кода, уменьшение размера файлов CSS и JavaScript.

- Использование кэширования для ускорения доступа к ресурсам сайта.

- Выбор хорошего хостинг-провайдера с высокой производительностью.

- Использование CDN (Content Delivery Network) для распределения ресурсов по различным серверам.

Приложение тщательного внимания к скорости загрузки страниц поможет улучшить опыт пользователей, повысить позицию сайта в поисковых системах и увеличить привлечение трафика на сайт.

Ошибки в файле robots.txt

Рассмотрим некоторые распространенные ошибки, которые можно совершить при написании файла robots.txt:

-

Ошибки синтаксиса: Неправильное использование синтаксических правил в файле robots.txt может привести к его неправильному распознаванию поисковыми роботами. Например, незакрытые скобки, неправильное использование директив и т.д. Старайтесь быть внимательными при создании и редактировании файла.

-

Неправильная блокировка: Иногда возникает ситуация, когда вместо блокировки конкретных страниц или разделов сайта, они оказывают доступными для индексации. Это может произойти из-за неправильного использования директив Disallow и Allow. Проверяйте внимательно, что вы блокируете и разрешаете.

-

Отсутствие или неправильное использование User-agent: User-agent — это обозначение для поискового робота, которому вы задаете инструкции в файле robots.txt. Если вы не указываете User-agent, то инструкции могут применяться ко всем поисковым роботам. Если же указываете, но не правильно, то инструкции могут быть неправильно распознаны.

Исправление ошибок в файле robots.txt важно для того, чтобы поисковые роботы корректно обрабатывали ваш сайт и индексировали его. Неверные инструкции в файле могут привести к нежелательным последствиям, таким как индексация нежелательных страниц или блокировка подходящего контента.

Поэтому будьте внимательны при создании, редактировании и проверке файлов robots.txt, чтобы избежать указанных выше ошибок.